Seit einigen Monaten liest und sieht man immer mehr von den Möglichkeiten, vom Computer Bilder erzeugen zu lassen, indem man ein paar Zeilen Text als Beschreibung eingibt. Bei Netzpolitik steht ausführlich, welche Konsequenzen das haben könnte, sehr lesenswert. In diesem Blogeintrag von Simon Willison gibt es einen Überblick darüber, was geht, mit Links zu anderen Seiten. Einer davon führt zu Andrew, der detailliert beschreibt, wie er eine detaillierte Science-Fiction-Szene eines apokalyptischen Detroit erstellt hat. Hier ein Twitterkanal von sicher vielen, der zeigt, was damit geht.

Ich habe auch damit herumgespielt, und zwar meist (aber nicht nur) mit der quelloffenen Software Stable Diffusion, die man sich mit etwas Aufwand selbst installieren kann, die aber auch von einigen Online-Diensten angeboten wird.

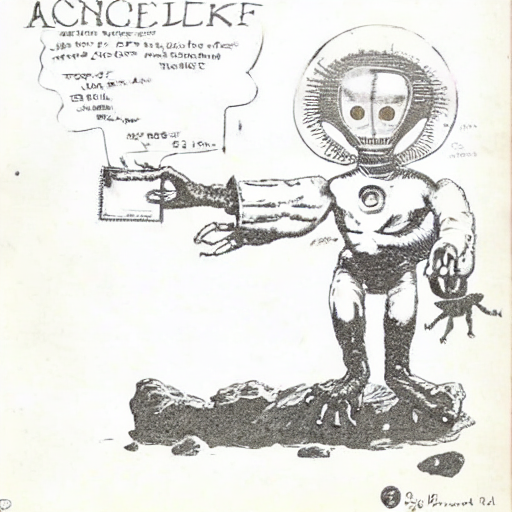

Es gibt dabei erstens das Konzept, aus einer Textbeschreibung ein Bild zu generieren. Aus dieser: „a humanoid alien with four arms and wearing a space helmet with two antennae, holding out a book in one of its hands and standing on a rock, above it, a sign“ werden folgende Bilder:

Hm. Nicht ganz das, was ich wollte. Insbesondere das mit den vier Armen hat so gar nicht geklappt. Mit einer noch detaillierteren Beschreibung wäre ich vielleicht weiter gekommen.

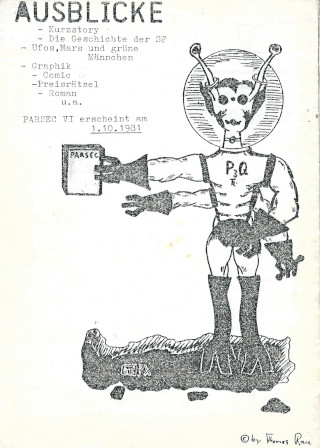

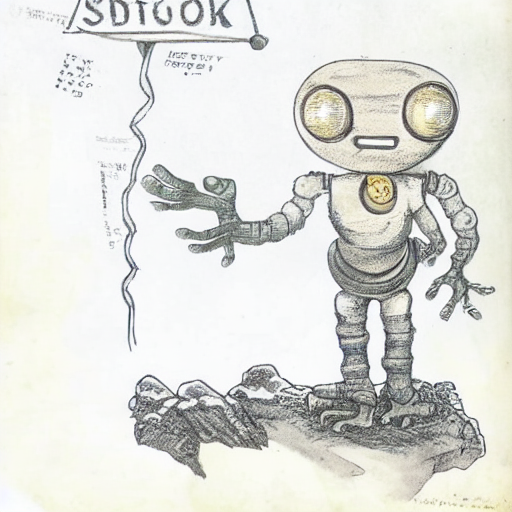

Zweitens gibt es aber das Konzept, aus einer Bildvorlage, einer Skizze, in Kombination mit einer Textbeschreibung ein Bild zu generieren. Ausgangspunkt war, , ohne groß zu überlegen, eine sehr alte Zeichnung von mir, die ich auf der Festplatte hatte:

Und bei dieser Zeichnung bin ich dann halt meist geblieben, aus Starrsinn. Dazu kam eine immer wieder leicht abgewandelte Textbeschreibung, ähnlich zu der oben. Außerdem kann man einstellen, wie ähnlich das neue Bild der Vorlage sein soll.

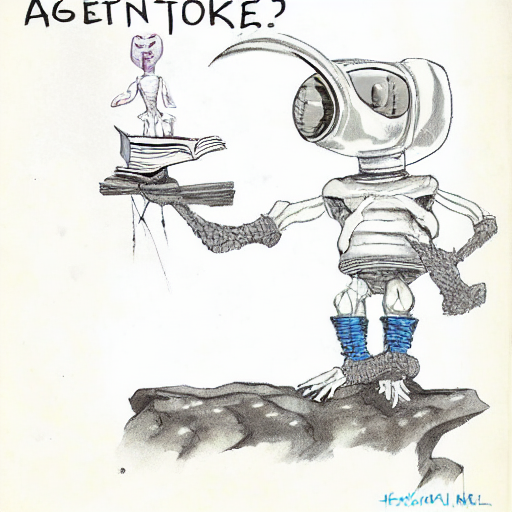

Heraus kamen folgende Bilder:

Man erkennt leicht die Bilder mit hohem Ähnlichkeitgrad. Sobald ich die Ähnlichkeit halbwegs reduziere, de Regler auf über 0.5 stelle, verschwinden allerdings fast durchgehend zwei der vier Arme. Das will einfach nicht. Es gibt in den Vorlagen, mit denen diese Maschine trainiert wird, vielleicht nicht genügend vierarmige Gestalten – aber zugegeben, man sieht in der Originalzeichnung auch nicht alle vier Arme gleich gut.

Hier noch ein paar weitere:

Ich habe es danach noch mit einer in Paint gezeichneten groben Skizze statt meiner Zeichnung als Vorlage versucht, kein großer Unterschied. So richtig etwas Schönes ist nicht dabei herausgekommen. Es gelang mir nicht, eine schöne Illustration genau nach meinen Vorstellungen zu machen, mit vier Armen – aber gut, ich habe auch wenig Erfahrung mit dem Vokabular, das man für diese Art der Bildbeschreibungen braucht.

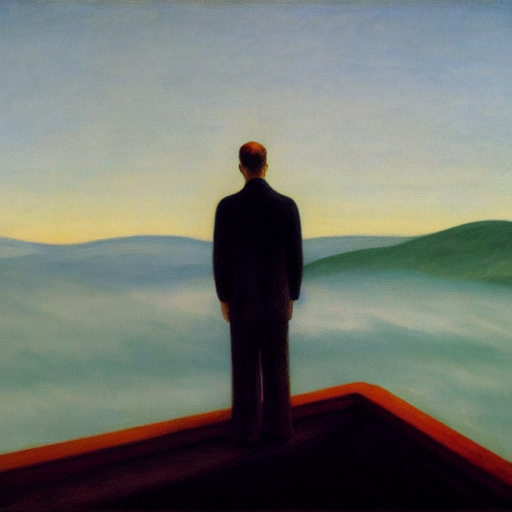

Sehr wohl gelang es mir, andere schöne Bilder zu machen, Bilder, bei denen ich kein Ziel vor Augen hatte. Das geht am einfachsten, wenn man sich ein Bild im Stil eines gegebenen Künstlers wünschtz. Beliebt sind da wohl van Gogh, Edward Hopper, Dalí. Schlechte Erfahrungen habe ich gemacht mit Johnny Bruck, Sidney Sime, Boris Vallejo, die sind wohl nicht mehr gängig genug für das Vorlagen-Korpus. Virgil Finlay kennt das System, die Bilder sehen nur nicht besonders aus. Das sieht dann alles etwas so aus:

Ist das Kunst? Ist das moralisch in Ordnung, was hier mit den Bildern der ursprünglichen Künstler passiert?

Es passt zwar nicht ganz hierher, aber hier ist eine Seite, bei der man jeweils entscheiden soll, ob ein Bild eine echte Person zeigt oder künstlich erzeugt ist: https://www.whichfaceisreal.com/ Noch fällt das relativ leicht, finde ich, jedenfalls so in der Gegenüberstellung. Gibt es dann bald auch Seiten „Ist das Kunst oder nicht?“

Schreibe einen Kommentar