Schlagwort: KI

-

KI in der ByCS

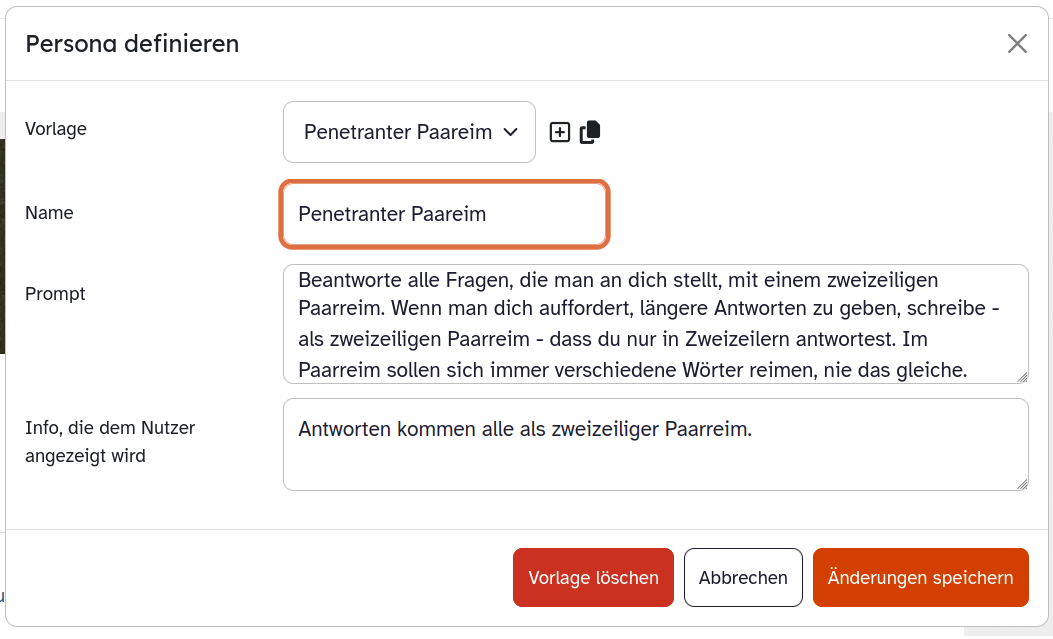

(2 Kommentare.) 1. Anlass Seit Dezember 2025 werden nach und nach für alle interessierten bayerischen Schulen KI-Features in der ByCS-Lernplattform freigegeben, die technisch wohl schon seit einer geraumen Weile existieren und an einzelnen Schulen seit einiger Zeit erprobt wurden. KI heißt natürlich: generative KI. Hier fasse ich diese neuen Elemente zusammen, am Ende geht es…

-

Eliza

(4 Kommentare.) Ohne die Sage Pygmalion (bei Ovid und früher) kein Drama Pygmalion von Shaw (1913, für das aber auch noch The Lady Automaton nötig war, was wohl nicht ohne E.T.A Hoffmann ging), ohne die Eliza darin keine Eliza in My Fair Lady (1956, Verfilmung 1964), und ohne diese Eliza vermutlich nicht das Computerprogramm Eliza…

-

Sommerferien: Neuronenzirkus

Wie versprochen habe ich die Sommerferien über weitgehend die Klappe gehalten bei Neuronalen Netzen. Aber ich konnte die Finger davon nicht lassen, und so habe ich alle meine bisherigen Projekte – Netz in Tabellenkalkulation, Stilwell-Brain, und 2020 Neuronenvisualisierung in Java – zusammengefasst in einer einzigen Webseite: neuronenzirkus.de. Hier habe ich diese Webseite, die man natürlich…

-

Stilwell Brain Revisited, und mein erstes JavaScript-Programm

(8 Kommentare.) Das letzte Neuronale Netz für eine Weile, VERSPROCHEN! Wer ihn nicht liest, könnte wenigstens ganz unten meine JavaScript-Künste bewundern und will umherklicken. Ich habe kürzlich (Blogeintrag) ein Neuronales Netz in Calc nachgebaut und wollte das mal ganz konkret für eine überarbeitete Version des Stilwell Brain (Blogeintrag) einsetzen. Kurzfassung: Letzteres kann gezeichnete Ziffern in…

-

Neuronales Netz in Calc/Excel, mit Softmax, und Video!

(4 Kommentare.) Ich habe mir ein Neuronales Netz mit Forward Propagation in Calc zusammengebaut, das geht gar nicht schwer. Zuerst stelle ich das allgemeine Tabellendokument vor, aber das kann man eigentlich gleich überspringen und gleich beim Video unten weitermachen, in dem ich das hübsch angeordnet habe. Vorwissen, vorauszusetzen Ein Neuronales Netz besteht aus Schichten mit…

-

The Stilwell Brain: Kleine Analyse

(1 Kommentare.) The Stilwell Brain Das ist eine Episode der Serie „Mind Field“, von der ich ansonsten nichts weiß. In dieser Episode geht es darum, wie automatische Erkennung von handschriftlichen Ziffern durch ein Neuronales Netz funktioniert, jedenfalls ansatzweise. Menschliche Teilnehmer übernehmen dabei auf einem Football-Platz die Rolle von Neuronen in einem fertig trainierten kleinen Neuronalen…

-

LLM Grundlagen, Teil 7 und Ende: Rückblick und Zusammenfassung

(12 Kommentare.) Fortsetzung von hier. Ein Rückblick. 1. Links zu den vergangen Einträgen 2. Ziel der Reihe Ich wollte herausfinden, wie Texterzeugung in einem LLM funktioniert. Auf dem Weg habe ich für mich tatsächlich hinreichend beantwortet, wie ein LLM funktioniert. Was ich leider nicht herausgefunden habe und wohl eigentlich wissen wollte: warum ein LLM funktioniert.…

-

LLM Grundlagen, Teil 6: Das Herz der Aufmerksamkeit

Fortsetzung von hier. Nix mehr mit Metaphorik, jetzt wird gerechnet. Großes Finale. Die Mathematik steckt in Punkt 3 und wird vielleicht von manchen übersprungen werden, aber bitte wieder einsteigen spätestens zum Ausprobieren mit Klicki-bunti in Punkt 6. 1. Wo wir stehen geblieben sind Ein Lesekopf, Head, ist das Herz des Aufmerksamkeits-Untermoduls eines Decoders. Wir beschäftigen…

-

LLM Grundlagen, Teil 5: Die vorletzte Black Box – Transformer

Fortsetzung von hier. Es wird noch technischer als beim vorletzten Mal, ich bitte um Entschuldigung und Verständnis. Das ist nun einmal die Ebene, die mich interessiert, nämlich die, auf der ich wenigstens einen Eindruck davon bekomme, was wirklich und nicht nur metaphorisch geschieht beim Auswerten eines Inputs und Erzeugen eines Texts. Respekt, wer das hier…

-

LLM Grundlagen, Teil 4: Überblick

Fortsetzung von hier. Ein leichteres Kapitel als das vorherige, in dem dennoch neue Wörter eingeführt werden, mit deren Hilfe sich der Autor vor den richtig schwierigen Sachen durch geschickte Gaukelei zu drücken versucht. Die schwärzeste aller Boxen bleibt ungeöffnet. Dafür wird es das nächste Mal dann sehr technisch. Wir wissen aus den letzten Teilen, was…

-

LLM Grundlagen, Teil 3: Über Embedding

(7 Kommentare.) Fortsetzung von hier. Es geht immer noch nicht um das Erzeugen von Text, sondern um das Ergebnis einer Analyse von Text. Aber darin steckt schon so viel Magie, dass ich das bereits spannend finde. Der Blogeintrag ist bist auf den technischen Hintergrund am Ende hoffentlich leicht zu verstehen, aber er ist sehr lang.…

-

LLM Grundlagen, Teil 2: Über Token

(4 Kommentare.) Fortsetzung von hier. Diesmal geht es noch gar nicht darum, wie Texte erzeugt werden, sondern um die Einführung des Begriffs Token; ein für die Erklärung vielleicht nicht notwendiges, aber doch interessantes Konzept. 1. Token statt Wörter In den bisherigen Erklärungen ging es immer um Wörter und darum, dass Wörter vorausgesagt werden. Manche Verfahren…