Monat: Januar 2009

-

Formale Sprachen, Teil 2: Reguläre Sprachen

(16 Kommentare.) Das ist die Fortsetzung dieses Eintrags. Heute will ich einen Einblick geben darüber, was eine Sprache vom Typ Chomsky 3 ausmacht. Diese Sprachen heißen reguläre Sprachen, sie können durch eine reguläre Grammatik (oder durch einen regulären Ausdruck) beschrieben werden. Mit einem endlichen Automaten kann man überprüfen, ob ein Wort zu einer Sprache gehört…

-

Formale Sprachen, Teil 1: Die Chomsky-Hierarchie

(25 Kommentare.) Mich hat noch nie jemand gefragt: Herr Rau, was lernt man eigentlich im Informatik-Studium? Deshalb hier eine Antwort. In der Informatik geht es um Information und deren automatische Verarbeitung. Ein Teilbereich heißt theoretische Informatik, und den mochte ich im Studium recht gerne. Jedenfalls viel lieber als technischere Informatik, Signalübertragung und dergleichen. In der…

-

„Night of the Living Dad“

Heute als Podcast gehört, und der Titel ist so gut, dass ich ihn übernehmen muss. Den Artikel von William Saletan kann man ganz bei Slate lesen. Die Kurzfassung: Das amerikanische Verteidigungsministerium interessiert sich für „a highly interactive PC or web-based application to allow family members to verbally interact with virtual renditions of deployed Service Members.“…

-

Material zu VERA 8

(4 Kommentare.) Ernst Klett Verlag stellt neue Reihe zu Vergleichsarbeiten in Klasse 8 vor. Westermann-Verlag: Kompetenztraing für Vergleichsarbeiten. Stark-Verlag: Vergleichsarbeiten 2009 – VERA 8. Wir erinnern uns, das sind schon wieder Tests, auf die sich Schüler nicht inhaltlich vorbereiten sollen. (Fußnote: Bin beim Weihnachtseinkauf erschrocken. Harmlose Physik- und ähnliche Experimentierkästen haben jetzt den Aufdruck „Natur-…

-

Freunde der klingonischen Oper

(3 Kommentare.) Heute nacht um 0:05 Uhr auf Deutschlandradio Kultur: juHrop („tschuh-rop“, dt. Heimweg), eine Klingonische Oper von Frieder Butzmann. Via netzpolitik.org, zu Details siehe dort. Ja, es ist genau das, an das man denkt. (Außerdem wird auf Bayern 2 um 21.30 Uhr die erste Folge von Jonas, der letzte Detektiv wiederholt. Die ersten 6…

-

Schulanfang 2009

(8 Kommentare.) Erster Schultag. Alle, die ich gesehen habe, waren wohlauf, aber ich habe noch nicht alle gesehen. Das Schulgebäude saukalt heute. Heizen ist wohl nicht in den Ferien. Arbeitsmaterial eines Schülers zu sehen gekriegt. Die 37 Lücken waren in keinem Fall mit den eigentlich einzusetzenden französischen Wörtern gefüllt, stattdessen war in jede Lücke ein…

-

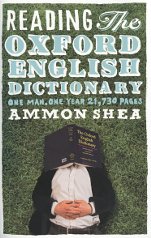

Exquisite Weihnachtsgeschenke

(5 Kommentare.) (Aus der Reihe: Alles muss raus. Blogbeiträge des Jahrs 2008 aufräumen.) Von meinen zwei Brüdern und deren Frauen habe ich dieses Jahr jeweils ein Buch zu Weihnachten gekriegt. Bücher, und das mir! Von beiden Büchern hatte ich noch nie gehört, und beide waren überraschend gelungene Geschenke. Reading the Oxford English Dictionary von Ammon…

-

Noch schnell ein Zoobesuch

(Aus der Reihe: Alles muss raus. Angefangene Blogbeiträge des Jahrs 2008 aufräumen.) Es gibt ein paar Tiere, bei denen schaue ich immer wieder vorbei. So lebhaft wie neulich habe ich die Vielfraße noch nie gesehen. Vielleicht gefällt ihnen die Kälte. Vielfraße sind die größten Mitglieder der Familie Marder. Die Männchen werden über 30 Kilo schwer.…

-

Das Braess-Paradoxon

(Aus der Reihe: Alles muss raus. Angefangene Blogbeiträge des Jahrs 2008 aufräumen. Diesmal wohl nur für Mathematikfreunde.) Vieles zum Braess-Paradoxon steht in Wikipedia. Auch die Illustrationen in diesem Blogbeitrag habe ich daraus genommen (Autor AlterVista, CC-BY-SA 3.0, Details hinter dem Link). Eigentlich wollte ich das selber und anders zeichnen, aber ich komme wohl doch nicht…