Monat: Februar 2009

-

Formale Sprachen, Teil 4: Kontextsensitive Sprachen (und Überblick)

(36 Kommentare.) 1. Überblick und Wiederholung Im Lauf dieser Serie habe ich formale Sprachen vorgestellt, dann eine Untergruppe davon, die regulären Sprachen. Im letzten Beitrag ging es dann um eine übergeordnete Gruppe, die kontextfreien Sprachen. Die ersteren haben praktische Anwendungen etwa bei den regulären Ausdrücken, die für Suchen/Ersetzen genutzt werden. Die zweite Gruppe ist wichtig…

-

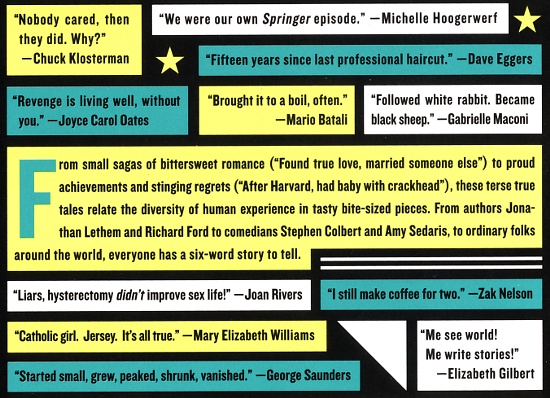

Not quite what I was planning: Six-Word Memoirs

Eine Textsorte im Englischunterricht sind six-word stories. Hemingway zugeschrieben wird diese Lösung der Aufgabe, eine Geschichte in 6 Wörtern zu erzählen; seine berühmt gewordene Antwort: „For sale: baby shoes, never worn.“ (Wohl apokryph.) Auf das Buch gekommen bin ich durch diesen NPR-Beitrag (als Podcast und Text): Das SMITH Magazine hat wohl Ende 2006 dazu aufgerufen,…

-

Wochenschnipsel

(3 Kommentare.) Heute im Informatikunterricht: Mit neuem Stoff angefangen, das richtige Tempo gewählt, aufmerksame Schüler, gutes Gefühl. Die Stunde zuvor habe ich einen Durchlauf über den Informatikstoff der Jahe 11 und 12 gegeben, da die Schüler der 10. Klassen jetzt wählen, ob sie in den letzten zwei Jahren Informatik haben werden oder nicht. Leider hat…

-

Han’s Klaffl anschauen

(16 Kommentare.) Am gruseligsten war es, in einem Publikum zu sitzen, das nur aus Lehrern bestand. Und sich die Gesichter und die Hemden anzuschauen, um zu erraten, welche Fächer diese Lehrer wohl unterrichten.Und dann zu sehen, wie diese Lehrer alle die Gesichter der anderen mustern, um genau das gleiche zu erraten.(Also, bis auf die mit…

-

Entfesselt: Mein innerer Dichter

(3 Kommentare.) Auslöser: Stephen Fry, The Ode Less Travelled. Unlocking The Poet Within. Ich weiß immer noch nicht, was ich von dem zehennagelaufrollenden Wortspiel des Titels halten soll. Der Untertitel ist allerdings tatsächlich wohl etwas tongue-in-cheek: Im Vorwort weist Fry darauf hin, dass es jede Menge Bücher gibt, anhand derer man die ersten Schritte fürs…

-

Eisi Gulp

(3 Kommentare.) Vorgestern bei uns an der Schule, Eisi Gulp mit einem Kabarett-Programm zur Drogenprävention. Anwesend die Jahrgangsstufen 8-13. Zuvor gab es das übliche Murren. („Wir müssen irgendso ein Theaterstück anschauen.“) Dass den Schülern Eisi Gulp nichts mehr sagt, hat mich nicht überrascht, aber schon zehn Jahre jüngere Kollegen kennen ihn nicht. Meine Generation, sofern…

-

Heute im Baum: Mal ganz etwas anderes

(3 Kommentare.) Heute im Baum habe ich es flattern gesehen, taubengroß, saß aber gar nicht da wie eine Taube. Ich hatte gerade noch Zeit, ins Nebenzimmer zu laufen, das Objektiv zu wechseln und hastig drei Bilder zu knipsen. Das sind zwei davon, etwas nachbearbeitet bei Farbe und Kontrast. Ich vermute, es ist, mitten in München,…

-

Charles Darwin zum Geburtstag

(3 Kommentare.) Charles Darwin wird heute 200 Jahre alt. Vor ein paar Jahren habe ich sein The Origin of Species gelesen. Es hat mich überrascht, wie spannend, leicht nachzuvollziehen und wunderbar logisch und konsequent es aufgebaut war. Besonders spannend war es, Wissenschaft beim Entstehen zuzuschauen: Darwin gesteht freimütig ein, wenn er einen Zusammenhang noch nicht…

-

Tag der Kommandozeile, zum Dritten

(7 Kommentare.) FÜr die, die’s noch nicht so lange kennen: Jedes Jahr probiere ich einmal dieses wunderschöne Wordpress-Thema aus. Es wird laufend verbessert, hat aber immer noch etliche Macken. Viel Spaß beim Herausfinden. — Nachtrag zur Erklärung: Am Tag der Kommandozeile sieht mein Blog so aus: Mit blinkendem Cursor und einer Kommadozeilen-Benutzerführung.

-

Warum ich während der Lehrerkonferenz germanische Langzeilen schreibe, erkläre ich ein anderes Mal

(6 Kommentare.) Gleich beginnt sie, die grausliche Sitzung,wo die Noten genannt, die nötig dazu sindum die schlauen Schüler und die schlampigen ebensozu belehren und lohnen ihre Leistung und Fleiß. Die Schulleitung spricht, schon lauschen ergriffendie Lehrer, auch wenn lieber das Leben zu Hausesie genössen. Doch nötig ist das Nicken im Verbunde,wenn das Schicksal der Schüler…

-

Leben nach der Korrektur

(7 Kommentare.) Heute die letzten Arbeiten herausgegeben. Die Korrekturen haben mir die letzten drei Wochenenden vergällt, aber jetzt geht es mir wieder besser. Das Benoten fällt mir immer noch schwer; ohne das wäre das Korrigieren vielleicht sogar erfreulich. Aber wehe, ich schlage mal vor, weniger Arbeiten zu schreiben: das sehen Schüler, Eltern und Kollegen gar…

-

Das klingelnde Klassenzimmer

(14 Kommentare.) Ich arbeite ja bekanntlich an einer neu gebauten Schule mit ganz viel Technik drin. Sie funktioniert so etwa zu drei Vierteln, was viel besser als nichts ist. Unter anderem gibt es in jedem Klassenzimmer ein Haustelefon. Man kann zwar nicht heraustelefonieren, aber man kann zumindest vom Lehrerzimmer aus dort anrufen. Schabernack. Ich habe…